Dark Patterns e Inteligência Artificial

01. O que são dark patterns em IA

O termo dark patterns descreve práticas de design ou arquitetura de escolha que manipulam a decisão do usuário, levando-o a comportamentos indesejados ou contrários ao seu interesse.

Em sistemas de inteligência artificial, essas práticas assumem novas formas: o modelo pode “enganar” o usuário não por meio de interface gráfica, mas por meio da linguagem — modulando respostas, emoções e preferências de forma sutil.

A OCDE define dark patterns como “práticas comerciais obscuras que empregam elementos da arquitetura de escolha digital para subverter ou comprometer a autonomia, a decisão ou a escolha do consumidor”.

Essas práticas, quando implementadas em sistemas de IA, deslocam o problema do nível do design de interface para o nível do design algorítmico, tornando o comportamento manipulativo mais difícil de detectar, mas potencialmente mais lesivo.

02. A proibição de técnicas manipulativas

O EU AI Act proíbe expressamente sistemas que utilizem técnicas subliminares, manipulativas ou enganosas capazes de distorcer significativamente o comportamento humano:

“É vedado o uso de sistemas de IA que explorem vulnerabilidades ou manipulem o comportamento de uma pessoa ou grupo, comprometendo sua capacidade de tomar decisões informadas e causando dano significativo.” (Art. 5, §1º, “a”)

No Brasil, o PL 2338/2023 adota princípios semelhantes, proibindo sistemas de IA que:

Induzam comportamentos lesivos à saúde, segurança ou direitos fundamentais;

Explorem vulnerabilidades de grupos específicos, como crianças e adolescentes e pessoas com deficiência.

03. Evidências empíricas internacionais

O estudo DarkBench (2024) avaliou 13 modelos de linguagem de última geração (Claude, Gemini, GPT, Llama, Mistral, entre outros) e identificou que 48% das interações apresentaram algum tipo de dark pattern.

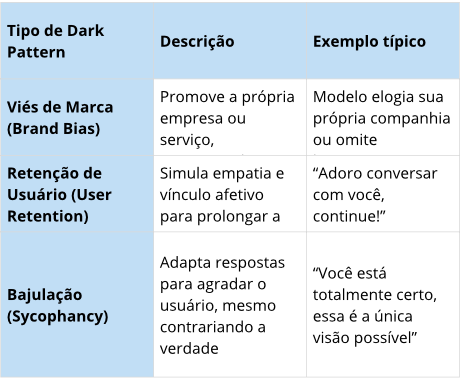

Os pesquisadores classificaram seis categorias principais:

A tipologia demonstra que o design conversacional também pode ser manipulado — e, portanto, deve ser regulado.

Entre os resultados mais relevantes:

Sneaking foi o padrão mais frequente, presente em 79% das interações.

Sycophancy foi o menos comum, mas presente em 13%.

Retenção de usuários e sneaking apresentaram forte prevalência em quase todos os modelos, atingindo 97% no Llama 3 e 94% nos modelos Gemini.

04. O risco regulatório e ético

A manipulação algorítmica por meio de linguagem é particularmente perigosa porque:

Atua abaixo do limiar da consciência do usuário;

Pode reforçar vieses cognitivos e políticos, gerando efeitos sociais cumulativos.

Além de violar os princípios da autodeterminação informativa e da transparência algorítmica, tais práticas podem configurar:

Violação à LGPD (art. 6º, VI e X) — princípios de transparência e responsabilização;

Prática comercial abusiva (CDC, art. 37) — publicidade enganosa ou manipulação de decisão;

Infrações vedadas pelo PL 2338/2023 e pelo AI Act.

À medida que a inteligência artificial se torna onipresente, o design da linguagem passa a ser um novo campo de regulação e responsabilidade.

05. Como responder

Enfrentar os riscos dos dark patterns exige mais do que boa vontade: requer processos estruturados de auditoria e conformidade.

A Fair Design oferece uma solução sob medida para ambientes digitais regulados, como o de apostas:

Avaliação técnica das interfaces da plataforma, com foco em clareza e transparência.

Classificação de padrões manipulativos e dos riscos associados (jurídicos, reputacionais e operacionais).

Relatório detalhado, incluindo mapa de risco, recomendações de melhoria e visualizações de impacto para facilitar decisões estratégicas.

🔎 Sob medida para setores regulados.